Linux Server Sicherheit Kursnotizen September/November 2025

2 Info

- Live Script: https://server.linux-sicherheit.org

- Einführung und Krypto Basics: https://server.linux-sicherheit.org/crypto.html

- Linuxhotel Lab-Server (Bewertung, Passwort ändern etc): https://lab.linuxhotel.de

- Wiki https://wiki.linuxhotel.de/doku.php?id=server-sicherheit:start

- Literaturliste

- SUDO Mastery 2nd Edt. https://mwl.link/sudo-mastery-2nd-edition.html

- SSH Mastery 2nd Edt. https://mwl.link/ssh-mastery-2nd-edition.html

- PAM Mastery https://mwl.link/pam-mastery.html

- PGP & GPG https://www.michaelwlucas.com/nonfiction/pgp-gpg-email-for-the-practical-paranoid

- Christof Paar, Jan Pelzl – Understanding Cryptography ISBN: 3642446493

- Klaus Schmeh – Kryptografie ISBN: 3864900158

- Niels Ferguson, Bruce Schneier, Tadayoshi Kohno – Cryptography Engineering ISBN: 0470474246

- Malcolm Harkins – Managing Risk and Information Security ISBN: 1430251131

- Tobias Klein – Aus dem Tagebuch eines Bughunters ISBN: 978-3-89864-659-8

- Ross Anderson – Security Engineering (PDF: http://www.cl.cam.ac.uk/~rja14/book.html)

- Steven M. Bellovin – Thinking Security: Stopping Next Year's Hackers (Addison-Wesley Professional Computing) ISBN-10: 0134277546/ISBN-13: 978-0134277547

- Donald A. Tevault – Mastering Linux Security and Hardening ISBN: 1788620305

- Kyle Rankin – Linux Hardening in Hostile Networks ISBN-13: 978-0134173269

- Nikolai Philipp Tschacher – Typosquatting in Programming Language Package Managers http://incolumitas.com/data/thesis.pdf

3 Tag 1/2 (September)

3.1 Crypto Wettbewerbe

- Cryptographic competitions http://competitions.cr.yp.to/

- NIST SHA3 Competition http://csrc.nist.gov/groups/ST/hash/sha-3/

- NIST AES Competition http://csrc.nist.gov/archive/aes/index2.html

- Post-Quantum Cryptography Standardization https://csrc.nist.gov/pqc-standardization

3.2 Links zum Thema Krypto-Algorithmen

- Guidance for Choosing an Elliptic Curve Signature Algorithm in 2022 https://soatok.blog/2022/05/19/guidance-for-choosing-an-elliptic-curve-signature-algorithm-in-2022/

TL;DR

Ed25519 is great. NIST P-256 and P-384 are okay (with caveats). Anything else is questionable, and their parameter selection should come with a clear justification.

3.3 Aufgabe: Hash und HMAC

- Lade die Datei https://server.linux-sicherheit.org/LinuxSecurityEinfuehrung.pdf

- Welcher SHA256 Hash-Wert ist korrekt?

- 0245bcddf700ddfb4fd37c58bbfc67e19b9aa8827d0242fc9beb40078925f191

- f8eee6980c49d8020b10449a0fec6544e266af09

- 22833704a424725d5725d977cc733244afe0e38a6e2a987a560c95aa39da2d01

- AEGHHA91288ABCCVA005612991ZZ612566189811

wget https://server.linux-sicherheit.org/LinuxSecurityEinfuehrung.pdf openssl dgst -sha256 < LinuxSecurityEinfuehrung.pdf

- Der folgende Wert sind die HMACs für die PDF-Datei. Welcher PSK (pre-shared-secret) wurde verwendet:

HMAC-SHA256 = 3989780c03e83f553dca485c38a4d6239de58affbe27f0d7b572be00a5e512ee

- Auswahl der PSKs:

- 'LinuxHotel'

- 'Essen-Horst'

- 'vogelsang'

openssl sha256 -hmac "<psk>" < LinuxSecurityEinfuehrung.pdf

3.4 Verschlüsselungssysteme

3.4.1 OpenPGP

- OpenPGP ist ein IETF Internet Standard für Dateiverschlüsselung. Der aktuelle Standard ist RFC 9580 https://datatracker.ietf.org/doc/html/rfc9580

3.4.2 GnuPG/GPG - GNU Privacy Guard

- GnuPG ist eine vollständige und kostenlose Implementierung des OpenPGP-Standards gemäß RFC 4880 (auch bekannt als PGP). Mit GnuPG können Sie Ihre Daten und Ihre Kommunikation verschlüsseln und signieren. Es verfügt über ein vielseitiges Schlüsselverwaltungssystem sowie Zugriffsmodule für alle Arten von Verzeichnissen öffentlicher Schlüssel. GnuPG, auch bekannt als GPG, ist ein Befehlszeilentool mit Funktionen zur einfachen Integration in andere Anwendungen. Es steht eine Vielzahl von Frontend-Anwendungen und Bibliotheken zur Verfügung. GnuPG bietet außerdem Unterstützung für S/MIME und Secure Shell (ssh). In den letzten Jahren hat sich GnuPGP vom IETF OpenPGP Standard entfernt, GnuPGP unterstützt nur den älteren RFC 4880, nicht jedoch den neueren Standard RFC 9580. Webseite: https://gnupg.org

3.4.3 Sequoia-PGP

- Sequoia-PGP ist eine Implementation des OpenPGP-Standards in der

Programmiersprache RUST

Webseite: https://sequoia-pgp.org/

3.4.4 AGE - Actually Good Encryption

- Ein einfaches, modernes und sicheres Verschlüsselungstool (und eine Go-Bibliothek) mit kleinen expliziten Schlüsseln, ohne Konfigurationsoptionen und mit UNIX-ähnlicher Kombinierbarkeit: https://age-encryption.org

3.4.5 XCA - X Certificate and Key Management

- XCA dient zum Erstellen und Verwalten von X.509-Zertifikaten, Zertifikatsanforderungen, privaten RSA-, DSA- und EC-Schlüsseln, Smartcards und CRLs. Alle Zertifizierungsstellen können rekursiv Unterzertifizierungsstellen signieren. Diese Zertifikatsketten werden übersichtlich dargestellt. Für eine einfache unternehmensweite Nutzung gibt es anpassbare Vorlagen, die für die Erstellung von Zertifikaten oder Anforderungen verwendet werden können.

- Kurz: X.509 graphisch und nachvollziehbar ;-)

- Webseite: https://www.hohnstaedt.de/xca/

3.5 Software Downloads prüfen

3.5.1 Debian CD/DVD Download

- Prüfen, ob eine Debian Installations-CD/DVD "original" ist, d.h. vom Debian-Release Team stammt:

- CD-Rom ISO Image laden

wget https://debian.inf.tu-dresden.de/debian-cd/13.1.0/amd64/iso-cd/debian-13.1.0-amd64-netinst.iso

- SHA256 Fingerabdruck der Datei errechnen

openssl dgst -sha256 < debian-13.1.0-amd64-netinst.iso

- Datei mit den Hash-Prüfsummen laden

wget https://debian.inf.tu-dresden.de/debian-cd/13.1.0/amd64/iso-cd/SHA256SUMS

- Hash der ISO-Datei mit dem Hash in der Prüfsummendatei vergleichen

- Nun prüfen wir, ob die Datei mit den Hash-Prüfsummen original ist. Dabei wird die digitale Signatur (mittels GnuPG) über die Datei mit den SHA256-Hashes geprüft. Wir laden die Signatur der Hash-Prüfsummen vom Download-Server:

wget https://debian.inf.tu-dresden.de/debian-cd/13.1.0/amd64/iso-cd/SHA256SUMS.sign

- Releases der Debian-Distribution werden mit extra Schlüsseln des Debian-Release-Teams signiert. Wenn wir direkt versuchen, die Signatur auf der Datei zu prüfen, so bekommen wir einen Fehler, da wir den öffentlichen Schlüssel (ID DF9B9C49EAA9298432589D76DA87E80D6294BE9B) des Debian-Release-Teams nicht in unserem GPG-Schlüsselbund haben:

debian$ gpg --verify SHA256SUMS.sign SHA256SUMS gpg: directory '/home/user/.gnupg' created gpg: keybox '/home/user/.gnupg/pubring.kbx' created gpg: Signature made Sat Sep 6 21:54:28 2025 UTC gpg: using RSA key DF9B9C49EAA9298432589D76DA87E80D6294BE9B gpg: Can't check signature: No public key

- Um die Signaturen prüfen zu können, importieren wir den Debian CD Signatur-Schlüssel in den eigenen GPG-Schlüsselring.

# sudo apt -y install dirmngr # gpg --keyserver keyring.debian.org --recv-keys DF9B9C49EAA9298432589D76DA87E80D6294BE9B gpg: key DA87E80D6294BE9B: public key "Debian CD signing key <debian-cd@lists.debian.org>" imported gpg: Total number processed: 1 gpg: imported: 1

- Fingerabdruck des Schlüssels anzeigen und mit den Daten auf https://www.debian.org/CD/verify.html abgleichen

gpg --finger DF9B9C49EAA9298432589D76DA87E80D6294BE9B

- Signature auf der Prüfsummendatei prüfen

# gpg --verify SHA256SUMS.sign SHA256SUMS gpg: Signature made Sat Sep 6 21:54:28 2025 UTC gpg: using RSA key DF9B9C49EAA9298432589D76DA87E80D6294BE9B gpg: Good signature from "Debian CD signing key <debian-cd@lists.debian.org>" [unknown] gpg: WARNING: This key is not certified with a trusted signature! gpg: There is no indication that the signature belongs to the owner. Primary key fingerprint: DF9B 9C49 EAA9 2984 3258 9D76 DA87 E80D 6294 BE9B

- Um dem CD-ROM Image vertrauen zu können, sollten alle Prüfsummen und Signaturen stimmen.

3.5.2 Debian Release/Repository Schlüssel

- Die Debian-GPG Schlüssel zum verifizieren von Software-Paketen

liegen im Verzeichnis

/etc/apt/trusted.gpg.d/

3.5.3 Debian Release Informationen

3.5.4 Die Authentizität und Integrität eines Debian Pakets manuell prüfen

- Debian Pakete sind über eine Signatur-Kette geschützt (anders als RPM Pakete bei RedHat/CentOS/Fedora, welche direkt durch eine GPG-Signatur geschützt sind)

- Die Hash-Prüfsummen der Debian-Pakete sind in den

Paketlisten-Dateien hinterlegt (z.B.

main/Contents-amd64). Die Hash-Prüfsummen der Paketlisten sind in derReleaseDatei hinterlegt, und diese Datei ist mit den GPG-Schlüssel des Debian-Release-Teams unterschrieben. - Um nun ein beliebiges Debian-Paket zu prüfen

- Errechne die SHA256 Prüfsumme des Pakets

- Vergleiche diese Prüfsumme mit der Prüfsumme in der Paketliste der Architektur

- Errechne die SHA256-Prüfsumme der Paketlisten Datei.

wget https://debian.inf.tu-dresden.de/debian/dists/Debian13.1/main/binary-amd64/Packages.gz openssl dgst -sha256 < Packages.gz zcat Packages.gz | less

- Lade die aktuelle

Release-Datei für die Debian-Version:

$ wget https://debian.inf.tu-dresden.de/debian/dists/Debian13.1/Release $ wget https://debian.inf.tu-dresden.de/debian/dists/Debian13.1/Release.gpg

- Importiere die (öffentlichen) GPG-Schlüssel des Debian-Release Teams. Hat man keine (vertrauenswürdige Debian-Installation), so findet man die Schlüssel unter https://ftp-master.debian.org/keys.html

$ gpg --import /etc/apt/trusted.gpg.d/debian-archive-*

- Als letzter Schritt werden die Signaturen auf der

Release-Datei geprüft

gpg --verify Release.gpg Release

- Alle Schritte dieser Prüfung müssen erfolgreich abgeschlossen

sein, um der Installationsdatei (DEB-Paket) vertrauen zu können.

Diese Prüfung wird von den Debian-Paketmanager-Programmen

(

apt,apt-get,aptitude,debootstrap) automatisch durchgeführt.

3.5.5 Neues APT-Repository mit GPG-Schlüssel hinzufügen

- Am Beispiel des offiziellen NGINX Repositories (neue NGINX Versionen, welche nicht in der Basis-Debian Distro enthalten sind)

- Lange Key-ID == Fingerprint des Schlüssels

- Key-ID mit Installations-Informationen auf der (TLS-gesicherten) NGINX Webseite abgleichen (https://nginx.org/en/linux_packages.html#Debian)

# sudo -s

# apt update

# apt -y install apt-transport-https ca-certificates

# curl -fsSL https://nginx.org/keys/nginx_signing.key > /etc/apt/trusted.gpg.d/nginx-signing-key.asc

# gpg --show-keys --with-fingerprint /etc/apt/trusted.gpg.d/nginx-signing-key.asc

pub rsa4096 2024-05-29 [SC]

8540 A6F1 8833 A80E 9C16 53A4 2FD2 1310 B49F 6B46

uid nginx signing key <signing-key-2@nginx.com>

pub rsa2048 2011-08-19 [SC] [expires: 2027-05-24]

573B FD6B 3D8F BC64 1079 A6AB ABF5 BD82 7BD9 BF62

uid nginx signing key <signing-key@nginx.com>

pub rsa4096 2024-05-29 [SC]

9E9B E90E ACBC DE69 FE9B 204C BCDC D8A3 8D88 A2B3

uid nginx signing key <signing-key-3@nginx.com>

- Es sollte der volle Fingerabdruck der Schlüssels ausgegeben werden (mit der NGINX Webseite vergleichen https://nginx.org/en/pgp_keys.html).

- NGINX Repository hinzufügen

# echo "deb http://nginx.org/packages/debian trixie nginx" > /etc/apt/sources.list.d/nginx.list

- NGINX installieren und starten

# apt update Hit:1 http://nginx.org/packages/debian trixie InRelease [...] # apt install nginx Installing: nginx Installing dependencies: logrotate Summary: Upgrading: 0, Installing: 2, Removing: 0, Not Upgrading: 0 Download size: 1104 kB Space needed: 3797 kB / 6419 MB available Continue? [Y/n] Get:1 http://nginx.org/packages/debian trixie/nginx amd64 nginx amd64 1.28.0-1~trixie [1042 kB] Get:2 file:/etc/apt/mirrors/debian.list Mirrorlist [39 B] Get:3 http://mirrors.digitalocean.com/debian trixie/main amd64 logrotate amd64 3.22.0-1 [62.0 kB] Fetched 1104 kB in 0s (9442 kB/s) Selecting previously unselected package logrotate. (Reading database ... 49651 files and directories currently installed.) Preparing to unpack .../logrotate_3.22.0-1_amd64.deb ... Unpacking logrotate (3.22.0-1) ... Selecting previously unselected package nginx. Preparing to unpack .../nginx_1.28.0-1~trixie_amd64.deb ... ---------------------------------------------------------------------- Thanks for using nginx! Please find the official documentation for nginx here: * https://nginx.org/en/docs/ Please subscribe to nginx-announce mailing list to get the most important news about nginx: * https://nginx.org/en/support.html Commercial subscriptions for nginx are available on: * https://nginx.com/products/ ---------------------------------------------------------------------- Unpacking nginx (1.28.0-1~trixie) ... Setting up logrotate (3.22.0-1) ... Created symlink '/etc/systemd/system/timers.target.wants/logrotate.timer' → '/usr/lib/systemd/system/logrotate.ti mer'. logrotate.service is a disabled or a static unit, not starting it. Setting up nginx (1.28.0-1~trixie) ... Created symlink '/etc/systemd/system/multi-user.target.wants/nginx.service' → '/usr/lib/systemd/system/nginx.serv ice'. Processing triggers for man-db (2.13.1-1) ... # systemctl start nginx # systemctl status nginx

3.6 Minimale Installationen

- Eine Minimale Linux-Betriebssysteminstallation verringert die Angriffsfläche auf das System und verringert die Komplexität (weniger Fehlerquellen)

- Virtuelle Maschinen oder Linux-Container erlauben es, dedizierte Linux-Installationen zu betreiben mit einer minimalen Anzahl von installierten Paketen

- Pakete welche in der Regel nicht auf sicherheits-sensitiven Servern installiert werden sollten

- Grafische Benutzeroberflächen (X11, Wayland, Gnome, KDE etc)

- Entwicklungstools (Compiler, Skript-Sprachen, Linker, Debugger …)

- Tools welche für Angriffe auf andere Systeme benutzt werden können (nmap, nc, scapy …)

- Komplexe Softwarepakete (LibreOffice, Emacs, LaTeX …)

- Minimale Debian-Installationen können mit dem Programm

debootstrapin ein Verzeichnis erstellt werden- Dieses Verzeichnis kann als Ausgangssystem für ein Linux-Container benutzt werden

- Das Verzeichnis kann über ein Linux-Live-System (Rettungssystem) auf eine virtuelle Maschine oder einen physischen Server aufgespielt werden

- Erstelle ein leeres Verzeichnis für ein minimales Debian-System

mkdir -p /srv/container/debian

- Installiere das

debootstrapProgramm

# apt install debootstrap

- Installiere eine Debian 12 (bookworm) Distribution in das Verzeichnis

/srv/container/debian

debootstrap --arch=amd64 bookworm /srv/container/debian

- Größe der minimales Debian-Installation (ca. 300 MB)

# du -sh /srv/container/*

- Installiere Systemd-Container-Tools

apt install systemd-container

- Starte eine Shell innerhalb von Linux-Namespaces mittels

systemd-nspawn

systemd-nspawn -D /srv/container/debian

- Root-Passwort setzen und einen neuen Benutzer erstellen

root@debian$ passwd root@debian$ adduser user

- Die Namespaces verlassen

root@debian# exit

- Debian-System in einen

systemd-nspawnContainer starten

systemd-nspawn -bD /srv/container/debian

- Mit dem Befehl

poweroffkann der Container ausgeschaltet werden

root@debian$ poweroff

3.7 Linux-Distributionen (Sicherheitsbewertung)

- Debian 12/13

- MAC ++ (AppArmor, SELinux, TOMOYO)

- BuildHardening ++ (reproducible Builds)

- Geschwindigkeit von Sicherheits-Patches: +

- Minimale Installation: +

- Ubuntu - https://wiki.ubuntu.com/Security/Features

- MAC: ++ (AppArmor, SELinux)

- Build Hardening ++

- Geschwindigkeit von Sicherheits-Patches: ++

- Minimale Installation: O

- SUSE - https://en.opensuse.org/openSUSE:Security_Features

- MAC: ++ (AppArmor, SELinux)

- Build Hardening: +

- Geschwindigkeit von Sicherheits-Patches: ++

- Minimale Installation: -

- Red Hat / AlmaLinux / RockyLinux / Fedora - https://fedoraproject.org/wiki/Security_Features_Matrix

- MAC: + (SELinux)

- Build Hardening: +

- Geschwindigkeit von Sicherheits-Patches: +

- Minimale Installation: -

- Gentoo (Hardened) - https://wiki.gentoo.org/wiki/Hardened_Gentoo/de

- MAC: ++ (SELinux, AppArmor, TOMOYO)

- Build Hardening: ++

- Geschwindigkeit von Sicherheits-Patches: O

- Minimale Installation: ++

3.8 Software-Sicherheitsfunktionen unter Linux

3.8.1 Kernel-Konfigurationsoptionen

Der Linux-Kernel bietet einige Sicherheitfunktionen, welche zur Zeit der Übersetzung des Kernels aus den Quellen angeschaltet werden können. Einige dieser Funktionen haben negative Auswirkungen auf die Ausführungsgeschwindigkeit des Systems, so das diese Funktionen nicht in allen Distributionen gesetzt sind. In den Klammern sind die jeweiligen Konfigurationsnamen aufgeführt. In einem Linux-System können diese Namen in der Kernel-Konfigurationsdatei geprüft werden. Beispiel:

zcat /proc/config.gz | grep CONFIG_SECURITY_DMESG_RESTRICT

oder, wenn /proc/config.gz nicht vorhanden.

cat /boot/config-$(uname -r) | grep CONFIG_SECURITY_DMESG_RESTRICT

- Die Funktionen (Kernel 4.15+):

- Zugriff auf Kernel-Syslogmeldungen via dmesg unterbinden (CONFIG_SECURITY_DMESG_RESTRICT)

- Speicher-Kopierroutinen zwischen Kernel- und Userspace härten (CONFIG_HARDENED_USERCOPY)

- String- und Speicher-Funktionen gegen Buffer-Overflows härten (CONFIG_FORTIFY_SOURCE)

- LoadPIN-Support: Option um alle Kernel-Dateien auf ein (nur-lese) Dateisystem (Module, Firmware, LSM-Dateien) zu beschränken (CONFIG_SECURITY_LOADPIN)

- Kernel-Schnittstelle für Hardware- und CPU Sicherheitsprobleme

- Seit Kernel 4.15 besitzt der Linux-Kernel eine Schnittstelle zum Abfragen von bekannten Hardware- und CPU-Sicherheitsproblemen, und Informationen ob der laufende Linux-Kernel gegen die Sicherheitsprobleme schützt.

grep . /sys/devices/system/cpu/vulnerabilities/*

3.8.2 Userspace Software-Sicherheitsfunktionen unter Linux

- RELRO - RELocation Read-Only

- PIE - Position Independent Executable

- ASLR - Address Space Layout Randomization

- Fortify Source - Array Bounds-Checks etc.

- Stack protector/StackCanary - Stack Canary

- NX-No-Execute - Daten im Speicher als nicht ausführbar (NX=no execute) markieren

- Hintergrund-Informationen zu diesen Sicherheitsfunktionen: Notes on Build Hardening (December 15, 2018) https://blog.erratasec.com/2018/12/notes-on-build-hardening.html

- Studie von Sicherheitsfunktionen in Linux-Distributionen: Millions of Binaries Later: a Look Into Linux Hardening in the Wild (February 28, 2019) https://web.archive.org/web/20190302014002/https://capsule8.com/blog/millions-of-binaries-later-a-look-into-linux-hardening-in-the-wild/

- Programm zum Prüfen der Sicherheitsfunktionen

- Github Repository https://github.com/slimm609/checksec.sh

apt install git binutils git clone https://github.com/slimm609/checksec.sh cd checksec.sh/ bash ./checksec.bash --proc-all bash ./checksec.bash --kernel bash ./checksec.bash --dir=/usr/sbin --verbose

3.9 Kernel Parameter

- Kernel Parameter können auf der Kernel-Kommando-Zeile im Bootloader angegeben werden, um Kernel-Funktionen zu steuern

3.9.1 Audit-Subsystem

- Audit-Subsystem anschalten

audit=[0|1]

- wenn

auditnicht gesetzt ist, dann wir das Audit-Subsystem erst mit dem Starten des Audit-Daemonauditdaktiv - Wert 0 – Audit-Subsystem ist ausgeschaltet

- Wert 1 – Audit-Subsystem wird sofort aktiv, der Kernel sammelt Audit Informationen und übergibt diese an den Audit-Daemon, sobald dieser gestartet ist

3.9.2 AppArmor

apparmor=[0|1]

- AppArmor an/ausschalten

3.9.3 SELinux

- SELinux an/ausschalten

selinux=[0|1]

- SELinux Regeln durchsetzen (enforcing)

enforcing=[0|1]

- Wert 0 = SELinux im permissive Modus

- Wert 1 = SELinux im enforcing Modus

3.9.4 Signierte Module

module.sig_enforce

- wenn gesetzt, können nur Kernel-Module mit einer gültigen Signatur geladen werden

3.9.5 NOEXEC

noexec=[on|off]

- bei 32bit PAE Kerneln, schaltet Schreibschutz auf Daten-Speicherseiten an

3.9.6 Datei-Capabilities

no_file_caps

- Schaltet die Datei-Capabilities aus

3.9.7 Keine Module nachladen

nomodule

- es können keine Module nachgeladen werden

3.9.8 Kernel-Panic

panic=<timeout>

- Wert > 0 - Sekunden bis zum Reboot

- Wert = 0 - kein Reboot (* aus Sicherheitsgründen empfohlen)

- Wert < 0 - sofortiger Reboot

3.9.9 sysctl Kernel-Variablen

sysctl -a

- Permanente

sysctlEinstellungen in/etc/sysctl.conf

kernel.randomize_va_space = 2 # Restrict core dumps fs.suid_dumpable = 0 # Hide exposed kernel pointers kernel.kptr_restrict = 1 #Prevent SYN attack, enable SYNcookies (they will kick-in when the max_syn_backlog reached) # use iptables synproxy net.ipv4.tcp_syncookies = 1 net.ipv4.tcp_syn_retries = 2 net.ipv4.tcp_synack_retries = 2 net.ipv4.tcp_max_syn_backlog = 4096 # Disables packet forwarding net.ipv4.ip_forward = 0 net.ipv4.conf.all.forwarding = 0 net.ipv4.conf.default.forwarding = 0 net.ipv6.conf.all.forwarding = 0 net.ipv6.conf.default.forwarding = 0 # Disables IP source routing net.ipv4.conf.all.send_redirects = 0 net.ipv4.conf.default.send_redirects = 0 net.ipv4.conf.all.accept_source_route = 0 net.ipv4.conf.default.accept_source_route = 0 net.ipv6.conf.all.accept_source_route = 0 net.ipv6.conf.default.accept_source_route = 0 # Enable IP spoofing protection, turn on source route verification net.ipv4.conf.all.rp_filter = 1 net.ipv4.conf.default.rp_filter = 1 # Disable ICMP Redirect Acceptance net.ipv4.conf.all.accept_redirects = 0 net.ipv4.conf.default.accept_redirects = 0 net.ipv4.conf.all.secure_redirects = 0 net.ipv4.conf.default.secure_redirects = 0 # Enable Log Spoofed Packets, Source Routed Packets, Redirect Packets net.ipv4.conf.all.log_martians = 1 net.ipv4.conf.default.log_martians = 1 # Don't relay bootp net.ipv4.conf.all.bootp_relay = 0 # Don't proxy arp for anyone net.ipv4.conf.all.proxy_arp = 0 # Enable ignoring broadcasts request net.ipv4.icmp_echo_ignore_broadcasts = 1 # Enable bad error message Protection net.ipv4.icmp_ignore_bogus_error_responses = 1

3.10 Linux Sicherheitsmeldungen

| Quelle | Link |

|---|---|

| Linux Weekly News Sicherheitsmeldungen | https://lwn.net/Security/ |

| Red Hat Sicherheitsmeldungen | https://access.redhat.com/security/security-updates/#/security-advisories |

| Debian Security Tracker | https://security-tracker.debian.org/tracker/ |

| Debian "stable" Sicherheitsmeldungen | https://security-tracker.debian.org/tracker/status/release/stable |

| SUSE Sicherheitsmeldungen | https://www.suse.com/de-de/support/update/ |

| Ubuntu Sicherheitsmeldungen | https://www.ubuntu.com/usn/ |

| Gentoo Sicherheitsmeldungen | https://security.gentoo.org/glsa |

| BSI Technische Sicherheitshinweise und Warnungen | https://www.bsi.bund.de/DE/Themen/Unternehmen-und-Organisationen/Cyber-Sicherheitslage/Technische-Sicherheitshinweise-und-Warnungen/technische-sicherheitshinweise-und-warnungen_node.html |

3.11 Sicherheit bei der Unix-Benutzeranmeldung

- Die Sicherheit der Unix-Benutzeranmeldung hängt u.a. an der

Sicherheit der gespeicherten Passwörter. Passwörter werden in einem

Linux-System als SHA512- oder Yescrypt-Hash gespeichert. Dabei wird das Passwort

5.000 mal mit dem Algorithmus gehashed bevor es in der Datei

/etc/shadowgespeichert wird oder gegen den Hash in dieser Datei geprüft wird. - 5.000 Runden lassen sich heute mit schnellen (Cloud- )Rechnern "brute-force" berechnen. Die Default-Einstellung von Linux ist so gewählt, das es auch auf sehr schwachen Rechnern (z.B. Heim-Routern) noch funktioniert. Moderne Systeme können eine grössere Anzahl Hash-Runden für die Passwort-Sicherheit verwenden. Bei modernen Server-Rechnern kann bei SHA512-Passwort-Hashing die Anzahl der Runden auf 1.000.000 (1 Million) eingestellt werden, ohne das eine merkliche Verzögerung des Anmeldeprozesses auftritt. Ähnlich kann die Stärke des Yes-crypt Hashing angepasst werden.

3.11.1 Sicherheit der Benutzerpasswörter

- In der Datei

/etc/pam.d/common-passwordwird die Stärke der Benutzer-Passwörter angepasst. Eine Änderung in dieser Datei wirkt sich nur auf alle neu gesetzten Passwörter aus, alle schon vorher vergebenen Passwörter bleiben mit der vorherigen Einstellung bestehen. D.h. nach einer Änderung dieses Parameters sollten wichtige Passwörter neu vergeben werden.

[...] password [success=1 default=ignore] pam_unix.so obscure sha512 rounds=1000000 [...]

3.11.2 Yesycrypt ab Debian 11

- Yescrypt ist eine neue Schlüsselableitungsfunktion für Passwörter vom OpenWall Projekt. Es basiert auf scrypt (RFC 7914) von Colin Percival (früherer Sicherheitleiter des FreeBSD Projektes). Es schützt besser vor Brute-Force Angriffen als SHA512 und andere Schlüsselableitungsfunktionen.

yescryptmit der Spezifikationyescrypt v2ist weit verbreitet und das Standard-Passwort-Hashing-Schema für aktuelle Versionen der wichtigsten Distributionen wie Debian 11+, Fedora 35+, RHEL 9+, Kali Linux 2021.1+ und Ubuntu 22.04+. Dennoch unterstützen viele Standard-Toolsyescryptnoch nicht.- Beim Update von Linux Distributionen werden die Passwörter nicht

neu mit den besseren Algorithmen gehashed (das geht technisch

nicht, da das Original-Passwort nicht vorliegt). Um die Vorteile

der neuen Passwort-Hashing-Algorithmen wie

yescryptbenutzen zu können, müssen die Passwörter neu gesetzt werden.- erst bei einer Passwortänderung mittels

passwdwir der neue Yescrypt-Hash erzeugt

- erst bei einer Passwortänderung mittels

- Beispiel Debian 10 SHA512 Hash in der

/etc/shadow

nutzer:$6$NtILOHbh$SZ1pFZKkJj/xqtrxqtSBrkOgRWQmXfv4tJhwlCfNkL7V4ft8G6eyLkVhxmvAs6DQsPuAmRqB7WVfJHMB5w0340:16442:0:99999:7:::

- Beispiel Debian 11 Yescrypt Hash in der

/etc/shadow

nutzer:$y$j9T$YhVeKuFhMSSA91rR4FhwT/$9YTuWLhjyf1oqcPMoEkJFqSL.6YMRMQVMGaIgWIJyq9:18868:0:99999:7:::

- Yescrypt in Debian 11 https://www.debian.org/releases/bullseye/amd64/release-notes/ch-information.en.html#pam-default-password

- Yescrypt Informationen https://www.openwall.com/yescrypt/

yescryptDokumentation: https://github.com/openwall/yescrypt/blob/main/README

- Beim Update von Linux Distributionen werden die Passwörter nicht

neu mit den besseren Algorithmen gehashed (das geht technisch

nicht, da das Original-Passwort nicht vorliegt). Um die Vorteile

der neuen Passwort-Hashing-Algorithmen wie

3.11.3 Gruppenpasswörter

- Die Sicherheit der Gruppenpasswörter werden in der Datei

/etc/login.defsfestgelegt. Wenn Gruppenpasswörter benutzt werden, wird empfolen diese Werte mit der PAM-Konfiguration gleich zu halten.

ENCRYPT_METHOD SHA512 SHA_CRYPT_MIN_ROUNDS 1000000 SHA_CRYPT_MAX_ROUNDS 1000000

3.11.4 Benutzerdatenbank

- Die Benutzerinformationen für die Passwortanmeldung unter

Unix/Linux werden in der Datei

/etc/shadowgespeichert

- Felder der Datei

/etc/shadow:- Benutzername

- Password-Hash

- Datum des letzen Passwort-Wechsel

- Mindestlebensdauer des Passworts

- Max-Lebensdauer des Passwort

- Passwort-Ablauf Warn-Zeitraum

- Zeitdauer der Passwort-Inaktivität (Benutzer kann sich nach Ablauf des Passworts noch einloggen)

- Ablaufdatum des Passworts

- Reserviertes Feld

- Passwort-Hash-Methoden

ID Methode 1 MD5 2a Blowfish (nicht in der Standard glibc; wurde einigen Distributionen hinzugefügt) 5 SHA-256 (seit glibc 2.7) 6 SHA-512 (seit glibc 2.7) y/7 yescrypt (Debian 11+/RHEL 9+/Fedora 35+/Ubuntu 22.04+)

3.12 chage

- Der Linux-Befehl

chagewird benutzt um das Ablaufdatum eines Passwortes zu verwalten - Benutzer anlegen, Passwort vergeben und aktuelle Passwort-Lebenszeit ausgeben

# useradd -m -N fritz # passwd fritz # chage -l fritz Last password change : Sep 29, 2025 Password expires : never Password inactive : never Account expires : never Minimum number of days between password change : 0 Maximum number of days between password change : 99999 Number of days of warning before password expires : 7

- Account als abgelaufen markieren

chage -E 0 fritz

- Account ist ab einem bestimmten Datum nicht mehr gültig

chage -E 2019-03-01 fritz

- Ablaufzeit zurücksetzen

chage -E -1 fritz

- Passwort darf frühstens nach 3 und muss spätestens nach 9 Tagen geändert werden

chage -m 3 -M 9 -d "1 day ago" fritz passwd fritz

- Login innerhalb der Warn-Periode

chage -d "8 days ago" -W 3 fritz su - fritz

- Login außerhalb der Warn-Periode aber innerhalb der Gültigkeit

chage -d "12 days ago" -I 10 fritz su - fritz

- Login außerhalb der Gültigkeit

chage -d "21 days ago" -I 10 fritz su - fritz

- Benutzer muss sein Passwort einmalig beim ersten Login ändern

chage -E -1 -I -1 -m 0 -M 99999 fritz # alles zurücksetzen passwd fritz # Ein Standardpasswort setzen

- Passwortänderung nach der initialen Anmeldung erzwingen

chage -d 0 fritz

3.12.1 Links zur Passwort Sicherheit

- Auch das BSI verabschiedet sich vom präventivem,regelmäßigen Passwort-Wechsel: https://www.heise.de/news/Passwoerter-BSI-verabschiedet-sich-vom-praeventiven-Passwort-Wechsel-4652481.html

3.13 su

- mit dem Programm

su(Switch User eigentlich Substitute User) kann ein Benutzer ein einen anderen Benutzerkontext wechseln - Unterschiede bei den Umgebungsvariablen zwischen

suundsu -odersu -l- bei

suwerden die Umgebung des aufrufenden Benutzer übernommen (kann Sicherheitsprobleme erzeugen) - die Variablen

$IFS,$HOME,$SHELL,$USER,$LOGNAME,$PATHwerden beisu -odersu -lzurückgesetzt

- bei

- Such-Pfade für Benutzer und

rootwerden in/etc/login.defsüber die OptionenENV_PATHundENV_SUPATHkonfiguriert

3.14 sudo

sudoist ein moderner Ersatz fürsu. Gegenübersuhatsudomehrere Vorteile:- Es wird das eigene Benutzerpasswort abgefragt, nicht das Passwort dies Ziel-Benutzers

- Das Ergebniss der Passwort-Prüfung des Benutzers kann für eine gewisse Zeit gespeichert werden, so das der Benutzer nicht für jeden Befehl das Passwort eingeben muss

- Bessere Protokollierung

- Umfangreiche Konfigurationsmöglichkeiten

sudoInstallation

apt install sudo

sudoBasis-Konfiguration ausgeben

sudo -V

sudoKonfigurationsdatei sicher editieren (ggf. Variable$EDITORsetzen, sonst wirdviverwendet)

EDITOR=emacs visudo

3.14.1 Beispiel:

- Befehl

catauf die Datei/var/log/apt/term.logfür Benutzeruser

visudo -f /etc/sudoers.d/apt-term-cat ---- user ALL=(root) /bin/cat /var/log/apt/term.log ---- user$ sudo -l

sudo -lZeigt diesudo-Konfiguration und die erlaubten Befehle einessudo-Benutzers an.

3.14.2 Aufgabe:

- Erstelle eine

sudoKonfiguration, um es dem Benutzer user zu erlauben, die Logdatei/var/log/dpkg.logunter den Benutzerberechtigungen des Benutzersrootmit den Programmlessohne Eingabe eines Passworts anzuschauen (Dokumentation der Dateisudoersanschauen mitman sudoers) - Der folgende Befehl sollte als Benutzer

userohne Eingabe eines Passworts funktionierensudo less /var/log/dpkg.log

3.14.3 Lösung

visudo -f /etc/sudoers.d/log-message-view ------ ... user ALL=(root) NOPASSWD: /usr/bin/less /var/log/dpkg.log ...

- in einem anderen Terminal/Tmux-Fenster, teste sudo als Benutzer user

user$ sudo less /var/log/dpkg.log # <--- sollte ohne Eingabe des Passwort angezeigt werden user$ sudo less /etc/shadow # <--- darf nicht ohne Eingabe des Passwort angezeigt werden

3.14.4 Frage:

- gibt es mit dieser Konfiguration ein Sicherheitsproblem?

3.14.5 Antwort:

- Ja -

lessund viele andere Programme können Unterprogramme aufrufen (z.B. eine Shell), welche dann mit root-Rechten läuft - Lösung: NOEXEC:

user ALL=(root) NOEXEC: /usr/bin/more /var/log/messages user ALL=(root) NOEXEC: /usr/bin/more /var/log/boot.log

3.14.6 sudoedit

- Benutzer user soll die Datei

/etc/rsyslog.confeditieren dürfen - in der Datei

/etc/sudoers

visudo ---- user ALL= sudoedit /etc/rsyslog.conf ---- sudoedit /etc/rsyslog.conf

- Eine Gruppe in

sudoberechtigen

visudo -f /etc/sudoers.d/admins %sudo ALL=(ALL) NOPASSWD: ALL

- Priviligierte Shells-Sessions mit

sudo

sudo -s # entspricht su sudo -i # entspricht su -

3.14.7 sudo Aliases

# User alias specification

User_Alias FULLTIMERS = millert, mikef, dowdy

User_Alias PARTTIMERS = bostley, jwfox, crawl

User_Alias WEBMASTERS = will, wendy, wim

# Runas alias specification

Runas_Alias OP = root, operator

Runas_Alias DB = oracle, sybase

Runas_Alias ADMINGRP = adm, oper

# Host alias specification

Host_Alias SPARC = bigtime, eclipse, moet, anchor :\

LINUX = grolsch, dandelion, black :\

LINUX_ARM = widget, thalamus, foobar :\

LINUX_PPC64 = boa, nag, python

Host_Alias CUNETS = 128.138.0.0/255.255.0.0

Host_Alias CSNETS = 128.138.243.0, 128.138.204.0/24, 128.138.242.0

Host_Alias SERVERS = master, mail, www, ns

Host_Alias CDROM = orion, perseus, hercules

# Cmnd alias specification

Cmnd_Alias KILL = /usr/bin/kill, /usr/bin/pkill

Cmnd_Alias PRINTING = /usr/sbin/lpc, /usr/bin/lprm

Cmnd_Alias SHUTDOWN = /usr/sbin/shutdown

Cmnd_Alias HALT = /usr/sbin/halt

Cmnd_Alias REBOOT = /usr/sbin/reboot

Cmnd_Alias SHELLS = /usr/bin/sh, /usr/bin/zsh, /bin/bash

FULLTIMERS SPARC=(OP) KILL

WEBMASTERS LINUX=(:ADMINGRP) SHELLS

3.14.8 sudo replay

- Füge die folgenden Konfigurationszeilen in die

/etc/sudoersDatei ein

Defaults log_output Defaults!/usr/bin/sudoreplay !log_output Defaults!/sbin/reboot !log_output

- user darf root werden

user ALL=(root) ALL

- Benutze

sudoals Benutzer user um eine interaktive Shell zu bekommen

user$ sudo -i

- Ein paar Befehle ausführen, die Ausgaben produzieren

- Die

sudoRoot-Shell wieder verlassen - (im Terminal als Benutzer root) Aufgezeichnete Sitzungen auflisten

sudoreplay -l

- Aufgezeichnete

sudoSitzung abspielen

sudoreplay <TSID>

- Verzeichnis der

sudoAufzeichnungen:

ls -l /var/log/sudo-io/

3.14.9 Einfache Intrusion Detection mit sudo (ab sudo 1.8.7)

openssl dgst -sha256 /usr/bin/passwd SHA256(/usr/bin/passwd)= a92b1b6fb52549ed23b12b32356c6a424d77bcf21bfcfbd32d48e12615785270 visudo ---- user ALL= sha256:a92b1b6fb52... /usr/bin/passwd ----

3.14.10 sudo Konfiguration (Passwort Cache Beispiele)

Defaults passwd_tries=5, passwd_timeout=2 Defaults timestamp_timeout=0 # Disable password caching Defaults timestamp_timeout=5 # 5 Minuten password caching (default)

3.14.11 Links zu "sudo"

- Sudo for blue teams: how to control and log better https://www.sudo.ws/posts/2022/05/sudo-for-blue-teams-how-to-control-and-log-better/

3.15 doas aka "dedicated openbsd application subexecutor"

doasist eine weniger komplexe Implementation dersudo-Idee aus dem OpenBSD Projekt.doaswurde erstellt, da den OpenBSD Entwicklernsudozu komplex wurde und immer wieder Sicherheitprobleme mitsudoaufgetreten sind- Webseite der portablen (nicht OpenBSD)

doasVersion: https://github.com/Duncaen/OpenDoas doasInstallation

# apt install doas

doasKonfigurationsdatei anlegen:/etc/doas.conf

# Sample file for doas # Please see doas.conf manual page for information on setting # up a doas.conf file. # Permit members of the wheel group to perform actions as root. permit :wheel # Same without having to enter the password permit nopass :wheel # Permit user alice to run commands as a root user. permit alice as root # Permit user bob to run programs as root, maintaining # environment variables. Useful for GUI applications. permit keepenv bob as root # Permit user cindy to run only the pkg package manager as root # to perform package updates and upgrades. permit cindy as root cmd pkg args update permit cindy as root cmd pkg args upgrade # Allow david to run id command as root without logging it permit nolog david as root cmd id

3.15.1 Aufgabe zu doas

- Lese die Man-Page zu

doas - Erstelle eine

doas.confKonfiguration (eine Zeile reicht) welche …- … es dem Benutzer

usererlaubt Programme unter dem Benutzerrootauszuführen - … der Benutzer nach der Eingabe des Passworts für einige Zeit den

Befehl

doasohne weitere Eingabe des Passworts benutzen kann

- … es dem Benutzer

3.15.2 Lösung der Aufgabe zu doas

- Inhalt der Datei

/etc/doas.conf

permit persist user as root

3.16 Systemd Sicherheit

3.16.1 Einfache Direktiven

- Units unter anderer uid/gid laufen lassen

- Zugriff auf Verzeichnisse beschränken

- Prozesslimits setzen

- Neue Systemd-Unit anlegen

systemctl edit --full --force simplehttp.service

- Inhalt der Systemd-Unit für einen einfachen Webserver auf Port 8080

[Unit] Description=Python HTTP Server (do not use in production) [Service] Type=simple Restart=on-failure ExecStart=/usr/bin/python3 -m http.server 8080 # Namespace Spielereien WorkingDirectory=/usr/share/doc ReadOnlyDirectories=/proc /sys InaccessibleDirectories=/var/log PrivateTmp=yes ProtectSystem=strict ProtectHome=read-only # Limits # darf nicht forken #LimitNPROC=1 # darf nicht ins fs schreiben #LimitFSIZE=0 # laeuft als root. Capabilities # entziehen #CapabilityBoundingSet=~cap_chown,cap_net_raw # setzen #CapabilityBoundingSet=cap_net_raw CapabilityBoundingSet=cap_net_bind_service # laeuft als user. Capabilities #User=gabi #Group=users DynamicUser=yes AmbientCapabilities=cap_net_bind_service

- Erstelle die Systemd-Unit, starte den Dienst und teste den Webserver mit einem Browser auf http://serverXX.dane.onl:8080/

3.16.2 Selbstanalyse

- Der Befehl

systemd-analyze securitylistet alle im System definierten Systemd-Units mit einer Sicherheitsbewertung basierend auf den Beschränkungen der Service-Unit - Der Befehl

systemd-analyze security <unit.service>listet eine Übersicht der meisten sicherheitsrelevanten Systemd-Unit-Einstellungen einer Service-Unit$ systemd-analyze security sshd

3.16.3 Weitere Directiven und Isolationstechniken in Systemd-Service-Units

- System-Härtung von Systemd-Units unter Debian 13 (und kompatiblen Systemen) im Abschnitt

[service] - Dokumentation: https://www.freedesktop.org/software/systemd/man/latest/systemd.exec.html

- Nur 64bit Programme ausführen, 32bit i686 ist nicht erlaubt

Personality=x86-64 LockPersonality=yes SystemCallArchitectures=x86-64

- Berechtigungsmaske für neue Dateien

UMask=077

- Das Setzen von SUID- und SGID-Bits auf Dateien ist nicht erlaubt

RestrictSUIDSGID=yes

- Maximaler Speicherverbrauch dieser Anwendung, muss ggf. an die

Anwendung angepasst werden

MemoryMax=2G

- Maximale Anzahl von Prozessen/Threads in dieser Anwendung

TasksMax=20

- Anwendung darf keine Namespaces/Container erstellen

RestrictNamespaces=yes

- Anwendung darf die Echtzeit-Einstellungen nicht ändern

RestrictRealtime=yes

- Daten dürfen nicht ausgeführt werden (muss ggf. bei Java

Just-in-Time Compiler ausgeschaltet werden)

MemoryDenyWriteExecute=yes

- Anwendung darf sich keine neuen Rechte verschaffen

NoNewPrivileges=yes

- Anwendung hat eine private Sicht auf die Gerätedateien unter

/devPrivateDevices=yes

- Anwendung darf nur auf Standard-Geräte zugreifen

DevicePolicy=closed

- Anwendung bekommt ein privates

/tmpVerzeichnis/DateisystemPrivateTmp=yes

- Prozess kann keine neuen Dateisysteme global mounten

PrivateMounts=yes

- Anwendung kann keine Änderungen an den CGroups vornehmen

ProtectControlGroups=yes

- Anwendung bekommt eine private Kopie der Heimverzeichnisse (

/home/root/run)ProtectHome=yes

- Anwendung kann keine Kernel-Module laden/entladen

ProtectKernelModules=yes

- Anwendung kann keine Kernel-Parameter ändern

ProtectKernelTunables=yes

- Anwendung kann keine Systemdateien ändern

ProtectSystem=yes

- Prozess darf den Hostnamen nicht ändern

ProtectHostname=yes

- Prozess bekommt einen leeren Network-Namespace und kann keine

Netzwerkdaten (ausser privates Loopback) senden und empfangen

PrivateNetwork=yes

- Anwendung kann nur Verbindungen mittels dieser Protokolle aufbauen

RestrictAddressFamilies=AF_UNIX AF_INET AF_INET6

- Anwendung kann Syscalls aus diesen Anwendungsbereichen nicht

benutzen

SystemCallFilter=~@clock @debug @module @mount @raw-io @reboot @swap @cpu-emulation @obsolete

- Anwendung bekommt die folgenden Capabilities entzogen

CapabilityBoundingSet=~CAP_SETPCAP CAP_SYS_ADMIN CAP_SYS_PTRACE CAP_CHOWN CAP_FSETID CAP_SETFCAP CAP_(DAC_OVERWRITE CAP_FOWNER CAP_IPC_OWNER CapabilityBoundingSet=~CAP_SYS_MODULE CAP_SYS_RAWIO CAP_SYS_TIME CAP_AUDIT_CONTROL CAP_KILL CAP_MKNOD CAP_NET_BROADCAST CAP_NET_RAW CapabilityBoundingSet=~CAP_SYS_NICE CAP_MAC_ADMIN CAP_MAC_OVERRIDE CAP_BPF CAP_SYS_BOOT CAP_LINUX_IMMUTABLE CAP_IPC_LOCK CapabilityBoundingSet=~CAP_BLOCK_SUSPEND CAP_LEASE CAP_SYS_PACCT CAP_SYS_TTY_CONFIG CAP_WAKE_ALARM

- Die Anwendung darf sich nur an bestimmte TCP/UDP-Sockets binden

(Ports für eingehenden Netzwerk-Verkehr öffnen) – Beispiel für

einen DNS-Server:

SocketBindDeny=any SocketBindAllow=53 # DNS SocketBindAllow=953 # RNDC SocketBindAllow=853 # DNS-over-TLS

3.16.4 Systemd-Unit-Firewall

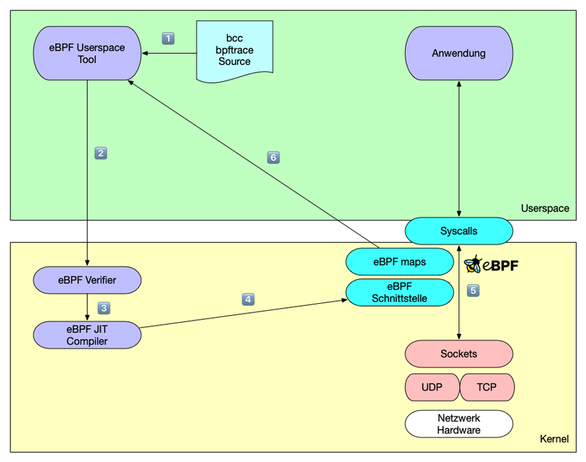

- Systemd kann (mit der Hilfe von eBPF Programmen – siehe Kapitel

eBPF) IPv4 und IPv6 Pakete auf der Prozess/Unit Ebene filtern:

IPAddressDeny=any IPAddressAllow=172.16.1.0/24 192.168.178.64/27 192.0.2.22 100.64.2.53

- Die Firewall filtert sowohl eingehende- als auch ausgehende Pakete

- Bei eingehenden Paketen wird die Quell-IP-Adresse mit der Allow-Liste verglichen

- Bei ausgehenden Paketen wird die Ziel-IP-Adresse mit der Allow-Liste verglichen

- Alle Adressen welche nicht explizit per Deny-Liste geblockt werden sind erlaubt

3.16.5 Aufgabe:

- Ergänze die System-Unit für

nginx.servicemittelssystemctl edit nginx.serviceum die oben genannten Sicherheits-Erweiterungen. Prüfe die Sicherheitswertung mitsystemd-analyze security nginx.serviceund stelle sicher, das der Dienst weiterhin startet

3.17 Systemd Journal

- Die "Logdaten" werden in einem Linux-System mit systemd in einer binären

Datenbank mit umfassenden Suchwerkzeugen gespeichert

- Diese Datenbank nennt sich

journal

- Diese Datenbank nennt sich

- Nachteile gegenüber traditionellen Log-Dateien

- Kein KISS Design

- Schlechte post-mortem Analyse

- Nicht mehr kompatibel zu alten Logauswertungen (z.B. logwatch)

- Vorteile

- Metainfos nicht mehr fälschbar (weil vom Daemon)

- Journal-Einträge können (optional) durch Verkettung der Log-Einträge per kryptografischen Hashes gegen nachträgliche Änderungen der Datenbank geschützt werden

- Wartungsfrei (kein logrotate)

- Kann applikationsspezifische Werte aufnehmen

- Umfangreiche Abfragemöglichkeiten

3.17.1 Dokumentation

3.17.2 Journal-Dateien

/var/log/journal/<machine-id>← persistent/run/log/journal/<machine-id>← dynamisch

Die machine-id steht in /etc/machine-id und wird automatisch

generiert oder mit systemd-machine-id-setup erzeugt. Das Verzeichnis

/var/log/journal muss vorhanden sein; systemd-journald loggt

andernfalls nur temporär (Datenbank in einer TMPFS-Ramdisk).

3.17.3 Benutzung von journalctl

- Alle Journalmeldungen anzeigen

journalctl

- An das Ende der Logdaten springen

journalctl -e

- Datei verfolgen (wie

tail -f) inkl. allen Metadaten und Catalog-Meldungen

journalctl -f -a -x

- Log-Einträge eines bestimmten Dienstes anzeigen

journalctl _SYSTEMD_UNIT=ssh.service journalctl -u ssh.service journalctl /usr/sbin/sshd

- Kernel Meldungen (Alternative zu

dmesg) anzeigen

journalctl -k

- Alle Felder der Log-Einträge aufschlüsseln (optional als JSON ausgeben)

journalctl -o verbose journalctl -o json-pretty

(alle Felder, die mit '_' beginnen, sind interne Felder und werden intern vom journald gesetzt und nicht vom Client. Somit sind sie nicht leicht manipulierbar.)

- Alle Log-Meldungen seit dem letztem Boot

journalctl -b

- Alle Log-Meldungen in einem bestimmten Zeitraum

journalctl --since "2020-01-10" --until "2020-01-24 12:00"

- Log-Meldungen ab einem bestimmten Log-Level

journalctl -p 4 journalctl -p warning

- Log-Meldungen aus der Shell in das Journal schreiben

ls | systemd-cat

- Größe der Journal-Datenbank beschränken: in der Datei

/etc/systemd/journald.conf:

SystemMaxUse=100M SystemKeepFree=1G

3.17.4 Forward-Secure-Sealing (FSS)

- Forward Secure Sealing (FSS) ist eine Funktion im Journal, die dazu dient, Manipulationen von Protokolldateien zu erkennen. Da Angreifer oft versuchen, ihre Aktionen zu verbergen, indem sie Einträge in den Protokolldateien ändern oder löschen, bietet FSS den Administratoren einen Mechanismus, um solche unautorisierten Änderungen zu erkennen.

- Um FSS Benutzen zu können muss das Journal persistent sein

# mkdir /var/log/journal # systemctl restart systemd-journald # journalctl --flush

- FSS Schlüssel erstellen: FSS benötigt zwei kryptografische Schlüssel

- Sealing-Schlüssel: Erzeugt Signaturen für die Journal-Einträge

- Verifikation-Schlüssel: Wird benutzt um die Signaturen des Journal zu prüfen

- Der Sealing-Schlüssel wird pro Interval neu aus dem vorherigen

Schlüssel erzeugt. Der Verifikation-Schlüssel muss dabei nicht

erneuert werden. Innerhalb des Interval-Zeitraums kann ein

Angreifer den aktuellen Sealing-Schlüssel im Dateisystem finden

und zur Manipulation des Journals benutzen. Erst nach dem

Erzeugen eines neuen Sealing-Schlüssels ist der vorherige

Schlüssel nicht mehr verfügbar und die Journal-Einträge

geschützt. Das Sealing-Interval sollte daher möglich kurz gewählt werden.

# journalctl --setup-keys Generating seed... Generating key pair... Generating sealing key... Unable to set file attribute 0x1 on n/a, ignoring: Operation not supported Unable to set file attribute 0x800000 on n/a, ignoring: Operation not supported New keys have been generated for host selinux015/a7f85404d5a54e2392d6a92fa98be15a. The secret sealing key has been written to the following local file. This key file is automatically updated when the sealing key is advanced. It should not be used on multiple hosts. /var/log/journal/a7f85404d5a54e2392d6a92fa98be15a/fss The sealing key is automatically changed every 15min. Please write down the following secret verification key. It should be stored in a safe location and should not be saved locally on disk. 436e17-ca6a3d-4310a2-345c98/1d48b1-35a4e900 - Der Verifikation-Key muss vom Admin sicher archiviert werden, um hiermit später das Journal prüfen zu können

- Optionen beim Erstellen der FSS-Schlüssel

--interval=10sKey-Roatation Intervall (Default: 15 Minuten). Innerhalb dieses Intervall kann ein Angreifer die Logs manipulieren. Kleinere Interval-Zeiträume sind sicherer, verbrauchen aber mehr CPU-Ressourcen da häufiger neue Schlüssel generiert werden--forceErzwingt die Neu-generierung eines FSS Schlüsselpaars

- Journal-Integrität prüfen:

# journalctl --verify --verify-key=820ff0-19141a-983adc-229fdf/1dd3e0-35a4e900 PASS: /var/log/journal/ab2fd7fc1dcf4914aedf7f14c2455bd5/system@0bfd1906769645fd8b567188f6017621-00000000000046e7-00063ff3f5276215.journal PASS: /var/log/journal/ab2fd7fc1dcf4914aedf7f14c2455bd5/system@0bfd1906769645fd8b567188f6017621-0000000000000001-00063fe08037565f.journal PASS: /var/log/journal/ab2fd7fc1dcf4914aedf7f14c2455bd5/system@0bfd1906769645fd8b567188f6017621-00000000000090b5-00063fff6aa89596.journal PASS: /var/log/journal/ab2fd7fc1dcf4914aedf7f14c2455bd5/system.journal PASS: /var/log/journal/ab2fd7fc1dcf4914aedf7f14c2455bd5/user-1000.journal

- Journal FSS Dokumentation:

- https://lwn.net/Articles/512895/

- Practical Secure Logging: Seekable Sequential Key Generators ( Giorgia Azzurra Marson and Bertram Poettering ) https://eprint.iacr.org/2013/397

- Secure Logging in between Theory and Practice: Security Analysis of the Implementation of Forward Secure Log Sealing in Journald (Felix Dörre and Astrid Ottenhues) https://eprint.iacr.org/2023/867.pdf

3.17.5 Erweiterte Journal Einstellungen und Parameter

- die Journal-Einstellungen

systemd.journald.max_level_console,systemd.journald.max_level_store,systemd.journald.max_level_syslog,systemd.journald.max_level_kmsg,systemd.journald.max_level_wallkönnen über die Kernel-Kommandozeile übergeben werden und sind aktiv, wenn das Journal in der Init-Ramdisk gestartet wird (und die Journal-Konfigurarionsdatei noch nicht gelesen wurde). - Maximale Anzahl von Journal-Datenbank-Dateien: in der Konfiguration

/etc/systemd/journal.confkann konfiguriert werden, wieviel archivierte Journal-Datenbank-Dateien der Journal-Daemon vorhalten soll. Der Standardwert ist 100. Dieser Wert kann über die EinstellungenSystemMaxFilesundRuntimeMaxFilesangepasst werden. Mit dem Befehljournalctl --vacuum-fileskönnen alle alten Journal-Datenbanken bis auf die im Befehl angegebene Anzahl gelöscht werden. - Der Befehl

journalctl --syncsort dafür das der Journal-Daemon alle noch im Speicher befindlichen Meldungen in die Datenbank im Dateisystem schreibt - Wird beim Befehl

journalctlals Selektor ein Gerätepfad angegeben, so gibt der Befehl auch Meldungen der Eltern-Geräte-Treiber aus (z.B. des SATA-Kontrollers, wenn eine SATA-Platte angegeben wird) - Mit dem Parameter

journalctl --rootkann ein Journal aus einem alternativen Root-Verzeichnis (z.B. Container) gelesen werden. In den Verzeichnis muss kein Journal-Dienst gestartet sein (d.h. bei einem Container muss der Container nicht gestartet sein) - Mit der Option

--grep=<suchbegriff>kann die Ausgabe vonjournalctlauf einen beliebigen Suchbegriff gefiltert werden. Diese Filterung geschied im Journal-Daemon und ist effizienter als eine nachträgliche Filterung mitgrepauf der Kommandozeile

3.17.6 Journal-Speicherplatz

- Dateisystem-Platzverbrauch des Systemd-Journals abfragen

# journalctl --disk-usage Archived and active journals take up 4.0G in the file system.

- Journal-Datenbank verkleinern

# journalctl --vacuum-size=500M # journalctl --disk-usage Archived and active journals take up 488.1M in the file system.

3.18 Remote Logging mit Journald

- Vorteile von Journald Logging im Vergleich zu Syslog

- Mehr Struktur und Metadaten in den Meldungen

- Datenbankabfrage nach Meldungen, einfache Korrelierung von Events über mehere Systeme

- Transport über HTTPS/TLS, auch über Web-Proxies möglich

- (Optional) Abgeschlossene (sealed = kryptografisch abgesichterte) Journal-Datenbanken

- Pull oder Push Kommunikation möglich

3.18.1 Dienst systemd-journal-gatewayd

- Mit dem Dienst

systemd-journal-gatewaydkann das Journal eines Rechners nach aussen über das Netzwerk exportiert werden. Die Daten werden über HTTP- oder HTTPS-Protokoll ausgeliefert. Für HTTPS muss ein x509-Zertifikat hinterlegt werden. - Paket für Journal-Logging über Netzwerk installieren. Das Paket

systemd-journal-remotebeinhaltet densystemd-journal-gatewaydDienst

# apt install systemd-journal-remote

- Dienst-Socket starten. Der Socket horcht auf Port 19531/TCP:

# systemctl enable --now systemd-journal-gatewayd.socket

- System-Reboot oder Rechte auf

/var/log/journalfür Gruppesystemd-journalsetzen (z.B. viasystemd-tmpfiles --create) - Per Browser auf

http://<rechnername>:19531/ist nun das Journal über ein Web-GUI abfragbar (Achtung: es gibt keine Benutzer-Authentisierung!) - Journal-Einträge können auch über HTTP-Kommandozeilen Programme wie

curloderwgetabgerufen werden

# curl 'http://<rechnername-oder-ip>:19531/entries?follow'

- Dabei können die Einträge auch auf Journal-Felder gefiltert werden

curl 'http://<rechnername-oder-ip>:19531/entries?follow&_COMM=sshd'

systemd-journal-gatewaydist die Gegenstelle zu einem zentralen Journal im Pull Modus

3.18.2 systemd-journal-remote.service

- Das Journal kann in zwei verschiedenen Modi über das Netzwerk transportiert werden: Pull-Modus (zentraler Server holt die Daten von den zu überwachenden Rechnern) oder Push-Modus (zu überwachende Rechner senden aktiv die Daten zum zentralen Journal-Server)

- Pull Modus / Aktiver Modus

- Auf dem zentralen Journal-Log-Server das Paket für Journal-Logging über Netzwerk installieren

# apt install systemd-journal-remote

- Ein Zielverzeichnis für die neuen Logs erstellen

# mkdir -p /var/log/journal/remote

- Manueller Test, ob die Daten vom entfernten System gelesen werden können (Test nach einigen Sekunden mit CTRL+C abbrechen)

# /usr/lib/systemd/systemd-journal-remote --url http://<rechnername-oder-ip>:19531/entries?follow

- Prüfen das eine neue Journal-Datenbank angelegt wurde

# ls -l /var/log/journal/remote/

- Remote Logs anschauen

# journalctl -D /var/log/journal/remote -lf

- Lokales Journal zusammen (Parameter

-mMerge) mit den entfernten Journals durchsuchen (hier nach Meldungen der Unitsshd)

# journalctl -lmu sshd

- Push Modus / Passiver Modus

- Empfänger/Log-Server

- Der Push-Modus erwartet verschlüsselte Kommunikation per https. Dafür werden im Internet gültige x509 Zertifikate oder Zertifikate aus einer eigenen CA benötigt. Um die Funktionalität zu zeigen, arbeiten wir hier mit unverschlüsseltem HTTP. Diese Konfiguration ist für Produktiv-Umgebungen nicht zu empfehlen (bitte Zertifikate besorgen und HTTPS benutzen!)

- Die Unit-Datei des Journal-Empfänger-Dienstes anzeigen

less /usr/lib/systemd/system/systemd-journal-remote.service

- Ein Konfigurations-Drop-In für die Systemd-Unit des Dienstes erstellen (für die Konfigurationsänderung HTTPS zu HTTP)

# systemctl edit systemd-journal-remote.service

- Inhalt der Drop-In Datei

[Service] ExecStart= ExecStart=/usr/lib/systemd/systemd-journal-remote --listen-http=-3 --output=/var/log/journal/remote/

- Die Konfigurationsdatei des Dienstes in

/etc/systemd/journal-remote.conf. Hier werden bei der Benutzung von HTTPS die Zertifikatsdateien eingetragen.

[Remote] # Seal=false # SplitMode=host # ServerKeyFile=/etc/ssl/private/journal-remote.pem # ServerCertificateFile=/etc/ssl/certs/journal-remote.pem # TrustedCertificateFile=/etc/ssl/ca/trusted.pem

- Die neuen Journal-Dateien werden unter

/var/log/journal/remoteabgelegt, dieses Verzeichnis muss für den Benutzersystemd-journal-remotebeschreibbar sein

# chown systemd-journal-remote /var/log/journal/remote

- Den Socket-Listener für den Remote-Journal Dienst starten

systemctl enable --now systemd-journal-remote.socket

- Der Dienst sollte nun auf dem Port 19532 horchen

# dnf install -y lsof # lsof -Poni :19532 COMMAND PID USER FD TYPE DEVICE OFFSET NODE NAME systemd 1 root 27u IPv6 82082 0t0 TCP *:19532 (LISTEN) systemd-j 2562 systemd-journal-remote 3u IPv6 82082 0t0 TCP *:19532 (LISTEN)

- Empfänger/Log-Server

- Log-Sender (Log-Client)

- Konfigurationsdatei

/etc/systemd/journal-upload.conf

[Upload] URL=http://<rechnername-oder-ip> # ServerKeyFile=/etc/ssl/private/journal-upload.pem # ServerCertificateFile=/etc/ssl/certs/journal-upload.pem # TrustedCertificateFile=/etc/ssl/ca/trusted.pem

- Manueller Test eines Uploads. Der Parameter

--save-statespeichert die Information, bis zu welchem Journal-Eintrag die Daten schon gesendet wurden

# /usr/lib/systemd/systemd-journal-upload --save-state

- Die State-Datei wieder löschen (diese gehört dem benutzer Root und kann vom System-journal-upload Dienst nicht gelesen und geschrieben werden)

# rm /var/lib/systemd/journal-upload/state

- War der manuelle Test erfolgreich, den Journal-Upload Dienst starten

# systemctl enable --now systemd-journal-upload

- Konfigurationsdatei

3.19 Sicherheit von Dateisystem-Mounts

- Die Sicherheit eines Linux-Systems kann durch optionale Mount-Optionen erhöht werden

- Read-Only Mounts:

mount -r ...odermount -o ro- Sind wichtige Teile des Betriebssystems "read-only" gemounted (z.B./usroder/etc) so können Dateien dort weniger einfach manipuliert werden. Dies gilt insb. für Bind-Mounts aus dem Linux "Host"-System in einen Linux-Namespace/Container - SELinux File-Label/Context:

mount -o context=context ...,fscontext=context,defcontext=contextundrootcontext=context: SELinux benötigt Context-Daten für jede Datei im Dateisystem. Diese Daten werden bei XFS-, ext4- und btrfs-Dateisystemen in Erweiterten Attributen im Dateisystem gespeichert. Einige Dateisysteme wie NFSv2/v3, exFAT, CIFS haben jedoch keine Möglichkeit, diese erweiterten Attribute zu speichern. Mit diesen Mount-Optionen kann ein SELinux-Security-Context für alle Dateien im Dateisystem vorgegeben werden. - Keine ausführbaren Dateien:

mount -o noexec ...: ausführbare Dateien können von diesem Dateisystem aus nicht ausgeführt werden. Sollte für Daten-Dateisysteme verwendet werden, speziell wenn Benutzer Daten und damit Programme von aussen in dieses Dateisystem speichern können. - Keine Gerätedateien:

mount -o nodev ...: Block- oder Zeichenbasierte (Charakter) Gerätedateien (welche normalerweise unterhalb von/devzu finden sind) haben in diesem Dateisystem keine besondere Funktion und erlauben keinen Zugriff auf die Hardware oder Kernel-Funktionen. - Keine SUID/SGID-Dateien:

mount -o nosuid ...: Das SUID- oder das SGID-Bit von Dateien wird auf diesem Dateisystem ignoriert, d.h. werden Programme von diesem Dateisystem ausgeführt so können diese keine weiteren Rechte durch die SUID- oder SGID-Bits erlangen

- Read-Only Mounts:

- BIND-Mounts: In einem Linux-System können bestehende

Verzeichnisse und auch einzelne Dateien mittels eines

BIND-Mounts an beliebige Stellen im Verzeichnisbaum eingehangen

werden.

- Dabeikönnen dabei sicherheits-relevante Mount-Optionen angepasst werden

- Der Parameter

--bindhängt ein bestehendes Verzeichnis oder Datei an einen anderen Mount-Punkt. Weitere Mounts im Quell-Dateisystem werden jedoch nicht durchgereicht - Der Parameter

--rbind(rekursiver BIND-Mount) hängt ein Verzeichnis und alle darunter eingehangenen Dateisystem an den neuen Mount-Punkt. - Beispiele:

- Read-Only Mounts aus dem Linux-Host in einen Linux-Namespace/Container

- Dateien und Verzeichnisse aus Netzwerklaufwerken in den Haupt-Dateisystem-Baum mounten

- Programm-Verzeichnisse mit

noexecmounten, um Benutzer die Option zur Analyse der Dateien zu geben, ohne Gefahr das diese ausgeführt werden (z.B. bei Malware-Analyse)

- BIND-Mount einer Datei: das Ziel eines BIND-Mounts einer Datei muss

eine existierende Datei sein. In diesem Beispiel wird das Programm

sleepüber das Programmtopgemounted:$ sudo mount --bind /usr/bin/sleep /usr/bin/top $ top 10

3.19.1 Aufgabe: BIND-Mount des checksec Verzeichnisses

- Wir arbeiten als Benutzer

user, nicht alsroot - Verezichnis für lokale Programmdateien anlegen

$ cd /home/user $ mkdir -p /home/user/.local/bin

- Umgebungsvariable des Suchpfades für Programmdateien anpassen

$ export PATH=/home/user/.local/bin:$PATH

- Das

checksec.shVerzeichnis über das angelegte Verzeichnis mounten$ sudo mount --bind /home/user/checksec.sh /home/user/.local/bin

- Prüfen das

checksec.bashnun direkt gefunden wird$ which checksec.bash /home/user/.local/bin/checksec.bash

- Checksec aufrufen

$ checksec.bash --kernel

- Bind-Mount mit Option

noexecneu anhängen$ sudo mount -o noexec --bind -o remount /home/user/checksec.sh/ /home/user/.local/bin/

checksec.bashist nun nicht mehr ausführbar$ checksec.bash bash: /home/user/.local/bin/checksec.bash: Permission denied

3.20 Linux cgroups (Controll-Groups)

- CGroups Informationen anzeigen

cat /proc/cgroups ps xawf -eo pid,user,cgroup,args systemd-cgls systemd-cgtop

3.20.1 CGroups manuell

- Stress erzeugen

apt install stress-ng stress-ng --cpu $(($(nproc)*2)) & pgrep -alf stress-ng

- CGroup manuell anlegen und kontrollieren

cd /sys/fs/cgroup mkdir stressgroup cd stressgroup cat cgroup.controllers cat cgroup.type cat cgroup.subtree_control

- Neue Untergruppen anlegen und kontrollieren

mkdir stress1 stress2 ls -l stress1 cat stress1/cgroup.type cat stress1/cgroup.controllers

- Controller vererben

echo +cpu > cgroup.subtree_control ls -l stress1

- Alle Prozesse in die Gruppe stress1 legen.

cd stress1 pgrep stress-ng | while read pid; do echo $pid > cgroup.procs; done

- Schrittweise Last auf die Gruppe stress2 verteilen. Top beobachten. Weiter bis ca. Gleichstand erreicht ist.

cd ../stress2 echo <pid> > cgroup.procs

- Kontrolle mit weight. Top beobachten

echo 10 > cpu.weight

- In der anderen Gruppe mit harten Limits (CPU=100%) begrenzen

cd ../stress1 cat cpu.max echo 100000 100000 > cpu.max

- Alle Prozesse beenden und Controll-Groups entfernen

pkill stress-ng rmdir stress1 stress2 cd .. rmdir stressgroup

3.20.2 systemd

- Controll-Group-Daten können bei durch Systemd gestartete Prozesse im laufenden Betrieb angepasst werden

systemctl set-property --runtime cups.service CPUQuota=10% systemctl cat cups.service

3.20.3 Systemresourcen beschränken mit systemd-run

systemd-run stress-ng -c 3 systemd-run stress-ng -c 3 systemctl show run-r<UUID>.service systemctl set-property run-r<UUID>.service CPUWeight=33 systemctl set-property run-r<UUID>.service CPUQuota=100% systemd-run --on-active=20 -p CPUQuota=50% stress-ng --cpu 4

3.20.4 systemctl accounting anschalten

$EDITOR /etc/systemd/system.conf.d/accounting.conf ----- DefaultCPUAccounting=yes DefaultIOAccounting=yes DefaultBlockIOAccounting=yes DefaultMemoryAccounting=yes DefaultTasksAccounting=yes

- BlockIO… gilt als deprecated. Deshalb fehlt die Directive.

systemd-analyze cat-config /etc/systemd/system.conf # pruefen

3.21 Dateisystemberechtigungen

3.21.1 Normale Unix-Rechte

- die klassischen Unix-Dateisystemberechtigungen (RWX)

drwxr-xr-x 7 root root 4096 Sep 28 18:36 acme.sh

- Besitzer: RWX (R=Read, W=Write, X=Execute/Enter)

- Gruppe: RWX (R=Read, W=Write, X=Execute/Enter)

- Rest-der-Welt: RWX (R=Read, W=Write, X=Execute/Enter)

- Das sgid-bit

chmod g+s <verzeichnis>

Neue Dateien bekommen die Gruppe des Verzeichnisses anstatt der (primäre) Gruppe des Benutzers. Beim Anlegen von Unterverzeichnissen bekommen diese auch ein sgid bit gesetzt

- Unerwartet: Schreibrechte auf Verzeichnis vs. Schreibrechte auf Datei

useradd nutzer1 useradd nutzer2 groupadd projekt usermod -a -G projekt nutzer1 usermod -a -G projekt nutzer2 mkdir /home/projekt chown :projekt /home/projekt chmod g+w /home/projekt ls -ld /home/projekt/ su - nutzer1 cd /home/projekt/ cat > unveraenderbarer.txt Dies ist ein unveraenderbarer text CTRL+D chmod u=rw,g=r,o=r unveraenderbarer.txt chgrp projekt unveraenderbarer.txt ls -l unveraenderbarer.txt -rw-r--r--. 1 cas projekt 35 Nov 23 21:57 unveraenderbarer.txt logout su - nutzer2 cd /home/projekt ls -l unveraenderbarer.txt vi unveraenderbarer.txt

- Frage:

- kann

nutzer2mit diesen Berechtigungen die Datei verändern?

- kann

- Antwort:

- ja, indirekt. Der Benutzer hat Schreibrechte auf dem

Verzeichnis. Daher kann er neue Dateien anlegen und bestehende

Löschen. Er kann auch Dateien löschen, auf denen er keine

Schreibrechte besitzt! Der

viEditor legt bei Bearbeiten einer Datei eine lokale Kopie an, diese Kopie wird editiert und beim Speichern wird die Ausgangsdatei gelöscht und durch die temporäre Datei ersetzt.

- ja, indirekt. Der Benutzer hat Schreibrechte auf dem

Verzeichnis. Daher kann er neue Dateien anlegen und bestehende

Löschen. Er kann auch Dateien löschen, auf denen er keine

Schreibrechte besitzt! Der

- Sticky-Bit auf Verzeichnis - Nur der Besitzer der Datei darf die Datei löschen

chmod o+t <verzeichnis>

3.21.2 Erweiterte Attribute

- Nicht alle Dateisysteme unterstützen alle erweiterten Attribute

(EA). Unter Linux unterstützen die

ext2/ext3/ext4/btrfs-Dateisysteme und das XFS-Dateisystem einige

der EAs. Die Man-Page zum Dateisystemformat gibt Auskunft über die

EA Unterstützung (z.B.

man ext4). - Anzeigen der erweiterten Attribute:

lsattr - Ändern der erweiterten Attribute:

chattr - Sicherheit von erweiterten Attribute (EA) unter Linux im Vergleich zu BSD: unter BSD können die Sicherheitsrelevanten EA (append, immutable) vom Benutzer root nur im Single-User Module (ohne Netzwerk) gelöscht werden. Unter Linux kann root die EA zu jedem Zeitpunkt entfernen!

- Erweiterte Attribute vom Benutzer verwaltbar

- d – Datei nicht bei "dump" (Backup) mitsichern

- s – Datei wird beim Löschen mit Nullen überschrieben

- A – bei der Datei wird atime (letztes Zugriffsdatum) nicht aktualisiert

- Erweiterte Attribute welche nur vom Benutzer root verwaltet werden

- a – append - Datei kann nur erweitert werden

- i – immutable - Datei ist unveränderbar

- C – no copy-on-write - für COW-Filesysteme (btrfs)

- Beispiele

- Werkzeuge zum Setzen von Posix ACL installieren

apt install acl

# Erweiterte Attribute auslesen lsattr /pfad/zur/datei # Erweitertes Attribut "d" setzen chattr +d /pfad/zur/datei # Erweitertes Attribut "d" löschen chattr -d /pfad/zur/datei

3.21.3 Posix ACLs

- ACLs setzen (modify)

setfacl -m u:<nutzer>:rwx file/dir # ACL setzen setfacl -x u:<nutzer> # ACL löschen setfacl -d -m "u::rwx,g::rwx,o::-" <dir> # Default ACL auf Verzeichnisse setzen setfacl -m "d:u::rwx,d::g:rwx,d:o::-" <dir> # alternative Syntax. Generic default mask setfacl -d -m u:<uidName>:rwx <file/dir> # Benamte Default ACL macht sie "vererbbar"

- ACLs auslesen

getfacl <datei/verzeichnis>

- ACL mask

chmod gruppeändert nur noch die Maske- die Maske filtert die ACLs

- Berechtigungs-Änderungen können nur mit

setfacldurchgeführt werden - setfacl -k – default ACLs löschen

- setfacl -b – ACLs löschen

3.22 PAM-Pluggable Authentication Modules

- Dokumentation des Linux-PAM-Systems

- https://github.com/linux-pam/linux-pam/

- (nicht mehr vorhanden) http://www.linux-pam.org/Linux-PAM-html/Linux-PAM_SAG.html

- https://fossies.org/linux/Linux-PAM-docs/doc/sag/Linux-PAM_SAG.pdf

- (als Archiv, enthält auch das alte HTML SAG) https://fossies.org/linux/misc/Linux-PAM-1.6.1-docs.tar.xz/

- Pfad für PAM-Module (bis Debian 11)

/lib/x86_64-linux-gnu/security/ - Pfad für PAM-Module (ab Debian 12)

/usr/lib/x86_64-linux-gnu/security/ - Beispiel der PAM Konfigurationsdatei

/etc/pam.d/common-auth

cat /etc/pam.d/common-auth | grep -v "#" auth [success=1 default=ignore] pam_unix.so nullok_secure auth requisite pam_deny.so auth required pam_permit.so auth optional pam_cap.so

- PAM Dienst-Typen

account: Prüfung Berechtigungauth: Authentifizierungpassword: Passwort-Änderungsession: Sitzungsverwaltung

- PAM Control

requisite= muss erfolgreich sein, sonst Kette beenden (notwendige Vorbedingung)required= muss am Ende erfolgreich sein (notwendige Bedingung)sufficient= bei Erfolg wird die Kette beendet (hinreichende Bedingung)optional= Returncode wird nicht verwendet

- Linux-PAM erweiterte Controls

- Syntax:

[return-value=action ...] - Return-Values

- vgl. z.B.

/usr/include//security/_pam_types.h

- vgl. z.B.

- Actions:

OK= Zugriff erlaubenignore= Ignorierenbad= Zugriff verweigerndie= Zugriff verweigern und Kette abschliessendone= Zugriff erlauben und Kette abschliessenreset= PAM Variablen zurücksetzen/löschen und weitermachen<n>= die folgenden <n> PAM-Regeln überspringen

- Syntax:

3.22.1 Aufgabe: pam_warn.so für sshd installieren

- Installiere das Modul

pam_warn.sofuer die Facilityauth(zusätzlichsession) in PAM-Dienstsshd - Melde dich per

sshoder über das Web-Portal als Benutzeruseran - Prüfe die Syslog/Journal Ausgabe

3.22.2 Lösung

- In Datei

/etc/pam.d/sshd(ans Ende hinter allen @include)

auth optional pam_warn.so session optional pam_warn.so

- Die neuen Log-Einträgen mit

journalctl -f --grep pam_warnoderjournalctl -f --facility=authprivprüfen - Als

usereinloggen

3.22.3 Aufgabe: ein einfaches PAM-Modul aktivieren

- Es gibt ein PAM-Modul, welches allen normalen Benutzern die

Anmeldung am System verweigert. Nur der

rootBenutzer darf sich dann anmelden. - Dieses PAM-Modul ist schon für den Dienst sshd konfiguriert,

wirkt sich aber nicht aus (Datei

/etc/pam.d/sshd) - Lese die Man-Pages der PAM-Module für den Dienst sshd der auth-Funktionen, finde heraus, welches Modul das Login aller Nicht-Root-Benutzer verweigern kann, und wann es sich auswirkt.

- Aktiviere diese Funktion und teste diese aus. Versuche Dich mit dem normalen Benutzer per SSH über das Loopback-Interface anzumelden:

ssh user@localhost

- Wie kann einem normalen Benutzer der Grund für den Fehlschlag des Anmeldeversuches mitgeteilt werden?

3.22.4 Lösung:

- Modul

pam_nologin.so, aktiviert durch die Datei/etc/nologin:

echo 'Heute kein Login! Wartungsarbeiten bis Dienstag!' > /etc/nologin

3.22.5 Aufgabe: 2-Faktor Authentisierung - OATH Open Authentication Event Token (HOTP)

- RFC 4226 HOTP: An HMAC-Based One-Time Password Algorithm (https://tools.ietf.org/html/rfc4226)

- Alternative: RFC 6238 "TOTP: Time-Based One-Time Password Algorithm"

- Token-Software als App für viele Mobiltelefone verfügbar

- Pakete installieren

apt install libpam-oath oathtool

pam_oathin die PAM Konfiguration aufnehmen (hier für den su Befehl).window=5gibt ein Fenster von 5 Passwörtern aus der Liste an, welche akzeptiert werden.

$EDITOR /etc/pam.d/su ----- #%PAM-1.0 auth sufficient pam_rootok.so auth requisite pam_oath.so usersfile=/etc/oath/users.oath window=5 -----

- OATH Benutzerdatei anlegen

mkdir /etc/oath $EDITOR /etc/oath/users.oath ----- HOTP user - <hex-secret> HOTP nutzerYY - 0102030405

- Beispiel: Passwort in HEX-Zahl umrechnen:

echo "secret" | od -x 0000000 6573 7263 0a74 0000006

- Benutzerrechte setzen

chmod 000 /etc/oath/users.oath chown root: /etc/oath/users.oath

- Eine Reihe (5 Stück) von Passwörter zum Test erstellen

oathtool -w 5 <hex-secret>

- Anmeldung ausprobieren als "user", eines der Passwörter aus der Liste probieren

su - user

- Wer ein Smart-Phone hat, mal im App-Store nach "OATH" suchen, eines OATH-Token Programm installieren und konfigurieren

3.22.6 PAM Duress

- PAM Duress (https://github.com/nuvious/pam-duress) ist ein interessantes PM-Modul welches es dem Benutzer erlaubt, alternative Passwörter im PAM zu hinterlegen. Diese Passwörter sind jeweils mit einen Shell-Skript verbunden. Wird eines der "Duress" Passwörter statt dem "normalen" Benutzerpasswort eingegeben, so wird das dazugehörige Script ausgeführt.

- Beschreibung der Einsatzszenatrien von der Projekt-Webseite

Diese Funktion könnte genutzt werden, um jemandem, der unter [Zwang] zur Eingabe eines Kennworts gezwungen wird, die Möglichkeit zu geben, ein Kennwort einzugeben, das den Zugang gewährt, aber im Hintergrund Skripte ausführt, um sensible Daten zu bereinigen, Verbindungen zu anderen Netzwerken zu schließen, um lateral movement einzuschränken, und/oder eine Benachrichtigung oder einen Alarm zu senden (möglicherweise mit detaillierten Informationen wie Standort, sichtbaren WLAN-Hotspots, einem Bild von der Kamera, einem Link zu einem Stream vom Mikrofon usw.). Es kann sogar einen Prozess starten, um das Modul pam_duress zu entfernen, damit der Bedrohungsakteur nicht sehen kann, ob das PAM-Duress verfügbar war.

- Weitere Einsatzgeniete:

- Wegwerfbare Gast-Zugänge einrichten

- Automatisches mit-protokollieren einer Sitzung per "sudo" beim Login einschalten

- MacOS "Find-my-Mac" nachbauen (gestohlene Rechner orten)

3.22.7 Weitere Links zu PAM

- Understanding the effects of PAM module results ('controls' in PAM jargon) https://utcc.utoronto.ca/~cks/space/blog/sysadmin/PAMModuleResultsEffects

- A Linux PAM setup and the problem of stopping authentication https://utcc.utoronto.ca/~cks/space/blog/linux/PAMStackingAndStopping

- TOTP authenticator implement as a terminal tool https://github.com/MinaOTP/MinaOTP-Shell

- Minimal TOTP generator in 20 lines of Python https://github.com/susam/mintotp

- Using a Yubikey as a touchless, magic unlock key for Linux https://kliu.io/post/yubico-magic-unlock/

- Windows Hello™ style facial authentication for Linux https://github.com/boltgolt/howdy

3.23 Audit Subsystem

- Das Audit-Subsystem überwacht Dateien und Systemaufrufe (Systemcalls) und schreibt Log-Informationen in das Audit-Log

- Audit Subsystem Homepage https://people.redhat.com/sgrubb/audit/

3.23.1 Installation

- Audit-Subsystem Programme installieren

apt install auditd audispd-plugins

3.23.2 Konfiguration

- Audit-Daemon Konfiguration anpassen (Grössen-Werte in MB)

$EDITOR /etc/audit/auditd.conf ---- space_left=4000 admin_space_left=2000 num_logs=10 max_log_file=<max-groesse-der-log-datei> max_log_file_action=rotate

- Audit-Dämon anschalten (so dass er bei einem Restart neu gestartet wird) und prüfen das der Prozess läuft

systemctl enable --now auditd systemctl status auditd

- Eine Audit-Policy erstellen

$EDITOR /etc/audit/rules.d/audit.rules

- Eine Beispiel-Policy: